最近,AI的兴起带火了原本只在游戏领域才受关注的GPU,甚至有人说,没有GPU就没有如今的人工智能,那么GPU到底特别在哪里呢?点击链接查看视频:https://mbd.baidu.com/newspage/data/videolanding?nid=sv_7169416907314495516

GPU也叫图形处理器(Graphics Processing Unit),顾名思义,是一种专门用于处理图形相关运算的处理器,它可以并行处理大量计算任务,从而提高计算速度和效率。

听起来不太好理解?我们举个简单的例子。

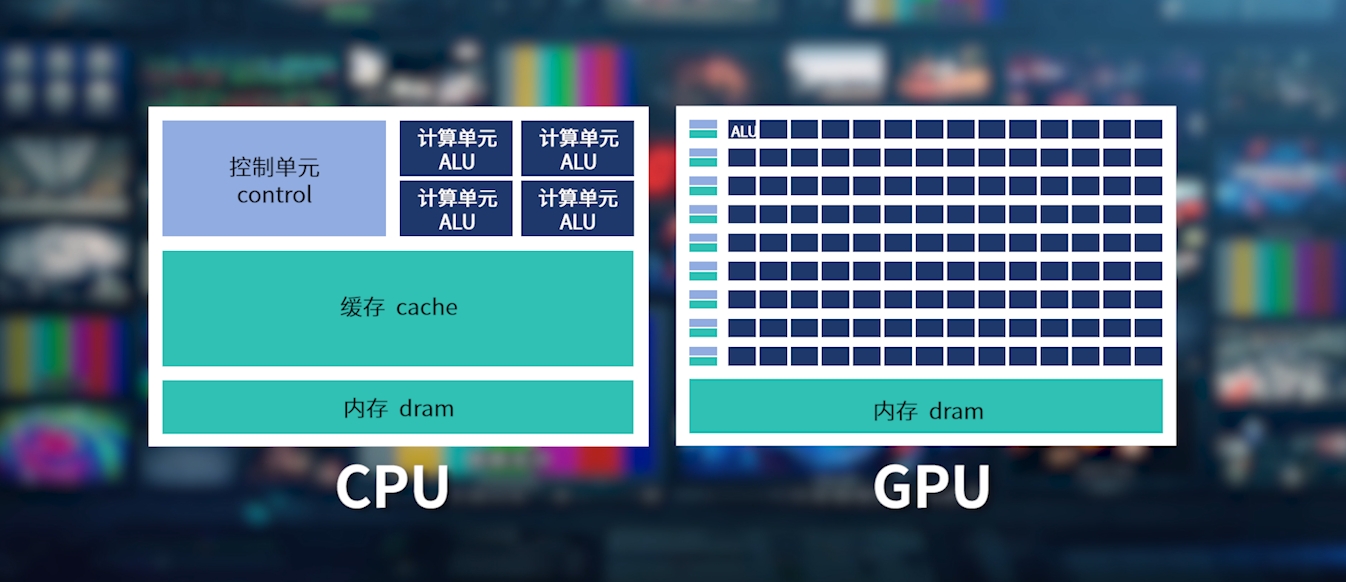

我们通常会以CPU,也就是中央处理器的计算能力与GPU进行比较,二者的主要架构就像图中所看到的这样。

假设计算机是一座工厂,现在工厂接到了新的任务,要生产一幅画,那么一个四核的CPU就相当于四个专业画家,四个人就算密切配合,每人左右手同时开工,每次最多只能画两笔。

而GPU就不同了,它有着大量用于计算的晶体管,就好像雇佣了大批的绘画工人,每个人拿着画笔,同时在画布的各个位置上作画,大大缩短了一幅画的生产时间,而这就是并行计算。

我们的屏幕通常由几百万个像素点组成,处理这些图像就需要很高的并行度,尤其是在一些高质量的渲染、光线追踪、视频编解码等工作中,你会很明显地感受到GPU的性能带给你的效率提升。

但相对于“专业的全能选手”CPU来说,GPU能够处理的海量计算其实都是简单的计算,也许一万个绘画工人中也诞生不了一个毕加索,但他们却能通过流水线作业,提高整个绘画工厂的产能。

而这种“流水线”这也正是人工智能训练所需要的。

基于神经网络的机器学习,就需要大量计算和数据处理,这些计算并不复杂,如果交给CPU,训练一个模型可能需要几周或者几个月,而在GPU上,几天甚至几个小时就能完成训练。最重要的是,GPU可以堆叠很多个计算单元(ALU),只要我的GPU够多,训练模型就能快人一步。

OpenAI使用了1万颗GPU训练ChatGPT,让GPU从游戏界“出圈”,彻底火了一把,但实际上,正是因为GPU的发展,才让人工智能有了今天的成果。

如今除了CPU和GPU,还诞生了很多专门用于各种计算处理的TPU、DPU、NPU等,未来,不同处理单元也许会有更多组合方式,为人工智能技术的发展带来新的可能。

关注微信公众号

关注微信公众号